Das Verhalten von CCMs lernt man am besten anhand eines konkreten Beispiels kennen, bei dem präzise, konsistente und belastbare KI-Schlussfolgerungen essenziell sind — über lange, fachlich anspruchsvolle Gedankenketten hinweg.

Wichtiger Hinweis: Bei dieser Art von Fallprüfung und Schlussfolgerungen sind viele Regeln zu beachten — dadurch entstehen lange Schlussfolgerungsketten. Und diese langen Schlussfolgerungsketten führen im Token-Raum zu einer Explosion der Kombinatorik — was die Bearbeitung solcher Fälle mit LLMs in der Praxis zu einer Herausforderung macht.

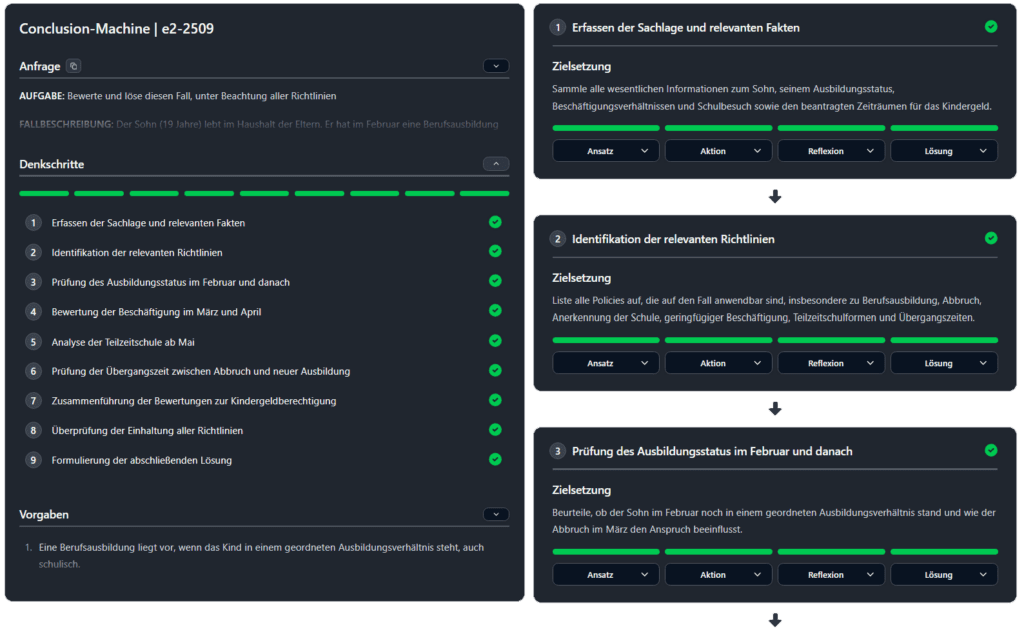

Der Sohn (19 Jahre) lebt im Haushalt der Eltern. Er hat im Februar eine Berufsausbildung (Einzelhandelskaufmann) im 3. Lehrmonat freiwillig abgebrochen. Im März und April hat er bei derselben Firma auf Basis eines Aushilfsvertrags (geringfügige Beschäftigung, 12 Std/Woche, 520 €) weitergearbeitet. Ab Mai besucht er eine private Berufsfachschule in Teilzeit (2 Tage Präsenz + 3 Tage Selbststudium) mit dem Ziel einer späteren Umschulung zum Ergotherapeuten. Die Schule ist vom Land nicht offiziell anerkannt, bietet aber Vorbereitung auf externe staatliche Prüfung an. Für März bis Juli wird Kindergeld beantragt.

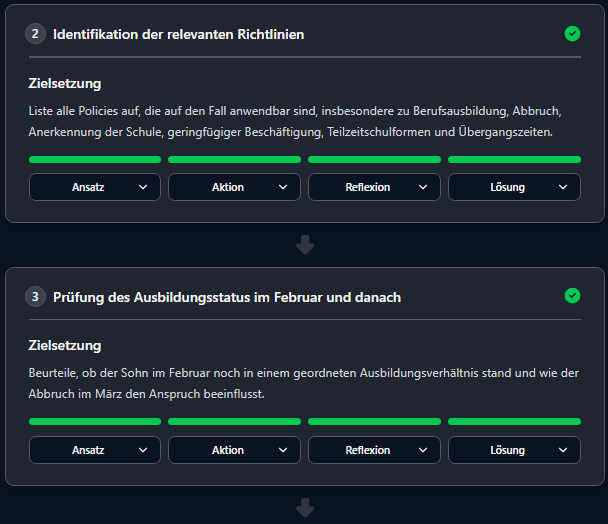

– POL-01: Berufsausbildung liegt vor, wenn das Kind in einem geordneten Ausbildungsverhältnis steht – auch schulisch.

– POL-102: Ein Abbruch der Ausbildung beendet den Anspruch, es sei denn, unmittelbar schließt sich eine neue berücksichtigungsfähige Maßnahme an.

– POL-103: Eine nicht anerkannte Schule kann bei ernsthafter Vorbereitung auf einen staatlichen Abschluss ausnahmsweise berücksichtigt werden.

– POL-104: Eine geringfügige Beschäftigung ist unschädlich, sofern keine hauptberufliche Tätigkeit vorliegt.

– POL-105: Teilzeitschulformen können als Berufsausbildung gelten, wenn regelmäßiger Unterricht im Kernbereich vorliegt.

– POL-106: Zwischen zwei Ausbildungsabschnitten ist eine Übergangszeit von max. 4 Monaten förderfähig, wenn die nachfolgende Ausbildung verbindlich geplant und vorbereitet ist.

Worum geht es bei dem Beispiel?

Es geht darum, eine gegebene Aufgabe unter Beachtung normativer Randbedingungen, also Vorschriften und Regeln, korrekt zu lösen. Dafür braucht es schrittweise Ableitungen, also reale ‚kognitive Arbeit‘.

Die Aufgabe erfordert eine präzise Prüfung von Anspruchszeiträumen gegen eine komplexe Policy-Logik (Ausbildung, Übergangszeiten, Ausnahmen). Ein einziger falscher logischer Schritt – z.B. das Übersehen einer 4-Monats-Frist – führt zu einem falschen Bescheid.

Wichtiger Disclaimer: Das Beispiel ist illustrativ

Der hier beschriebene Case und die nachfolgenden Ausführungen dienen zur Illustration der Arbeitsweise von CCMs. Das Funktionsprinzip von CCMs ist jedoch in keiner Weise auf „Kindergeld“ beschränkt.

CCMs arbeiten Domänen-agnostisch

Im Gegenteil: CCMs „denken“ Domänen-übergreifend, auf Basis allgemeinen Weltwissens und universell gültigem, deduktivem Denken. Individuelles, Organisations-spezifisches Wissen lässt sich jedoch problemlos als externe Quelle anbinden — ohne dass aufwändiges Training erforderlich wäre. Falls Sie jedoch bereits über individuell trainierte LLMs verfügen, können wir diese passgenau integrieren.

Kontaktieren Sie unser Solution Team, wenn Sie mehr über die unterschiedlichen Integrations-Szenarien wissen möchten.

Das Modell nutzt diese Quellen nicht als bloße Inspiration, sondern als bindende Constraints für den Denkprozess.

Safety First: Wenn das CCM feststellt, dass die vorliegenden Informationen oder Regeln zu einem Widerspruch führen, bricht es den Prozess kontrolliert ab oder fordert Klärung an. Das Prinzip lautet: Lieber keine Antwort, als eine halluzinierte falsche Antwort.

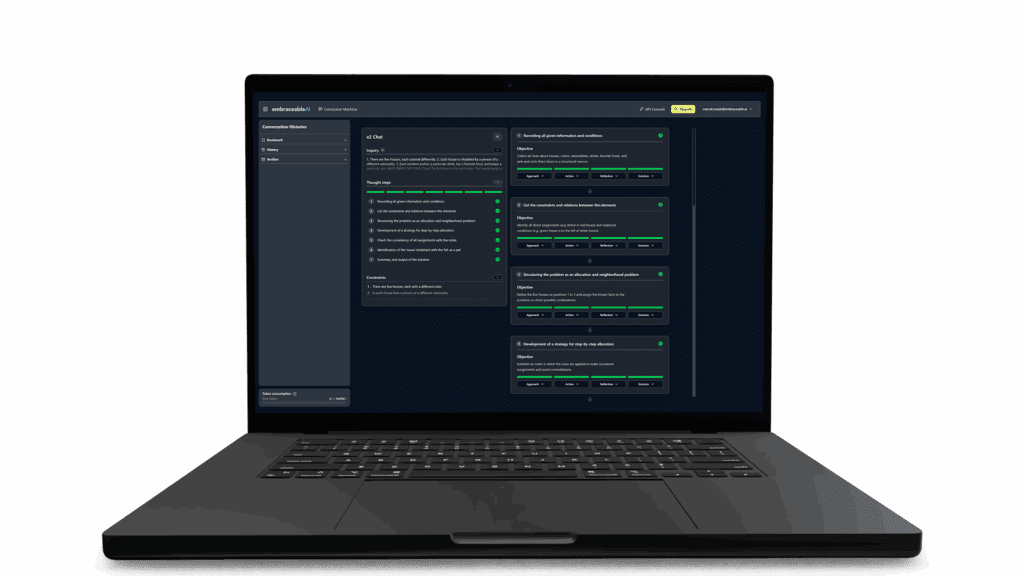

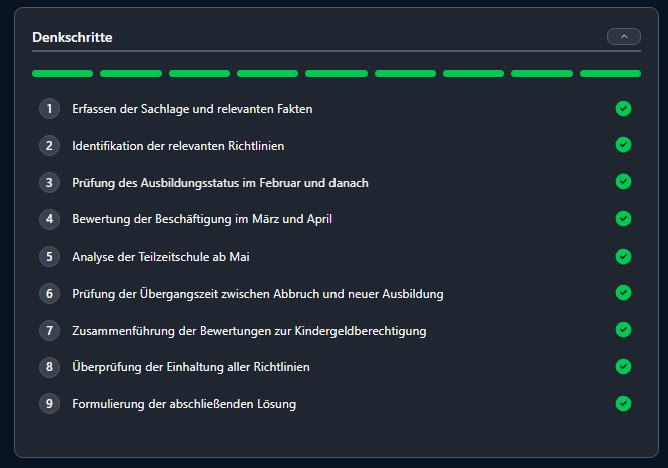

Die Lösung entsteht nicht in einer „Black Box“. Das CCM zerlegt das komplexe Problem in atomare, logische Einheiten. Jeder Schritt baut auf dem vorherigen auf:

Fakten-Extraktion: Welche Daten liegen für den Zeitraum vor?

Regel-Anwendung: Greift POL-106 (Übergangszeit) in diesem spezifischen Monat?

Zwischen-Fazit: Status für Teilabschnitt X ermittelt.

Verletzt dieser Schritt eine Policy? -> Blockieren.

Ist die logische Herleitung valide? -> Akzeptieren.

Dieser lineare, kausale Ablauf verhindert das „Verlaufen“ im Token-Raum, das bei LLMs oft zu instabilen Ergebnissen führt.

Diese kontinuierliche Selbstüberwachung (Self-Correction) sorgt dafür, dass sich Fehler nicht durch die Kette fortpflanzen. Das Ergebnis ist eine drastisch reduzierte Halluzinationsrate.

Die Lösung entsteht nicht in einer „Black Box“. Das CCM zerlegt das komplexe Problem in atomare, logische Einheiten. Jeder Schritt baut auf dem vorherigen auf:

Fakten-Extraktion: Welche Daten liegen für den Zeitraum vor?

Regel-Anwendung: Greift POL-106 (Übergangszeit) in diesem spezifischen Monat?

Zwischen-Fazit: Status für Teilabschnitt X ermittelt.

Verletzt dieser Schritt eine Policy?

-> Blockieren.

Ist die logische Herleitung valide?

-> Akzeptieren.

Dieser lineare, kausale Ablauf verhindert das „Verlaufen“ im Token-Raum, das bei LLMs oft zu instabilen Ergebnissen führt.

Diese kontinuierliche Selbstüberwachung (Self-Correction) sorgt dafür, dass sich Fehler nicht durch die Kette fortpflanzen. Das Ergebnis ist eine drastisch reduzierte Halluzinationsrate.

Am Ende erhalten Sie nicht nur das Ergebnis der Schlussfolgerungkette (samt Begründungen), sondern den kompletten Audit Trail. Sie können exakt nachvollziehen, warum das Modell so entschieden hat:

Auf welche Policy hat es sich berufen?

Welches Faktum war ausschlaggebend?

Wie war die logische Kette?

Dieses Maß an Transparenz und Granularität macht KI-Entscheidungen revisionssicher und nachvollziehbar – ein Muss für regulierte Branchen.

LLMs sind fantastische Werkzeuge für Kreativität und Assistenz. Doch wenn es um belastbare Schlussfolgerungen in geschäftskritischen Unternehmensprozessen geht, wird hohe stochastische Unschärfe in langen Gedankenketten zum unerwünschten oder gar inakzeptablen Risiko.

CCMs adressieren diesen „Skill Gap“: Um Schlussfolgerungen zu ermöglichen, die realer kognitiver Arbeit auf dem Niveau menschlicher Experten entspricht — also mit hoher Präzision, Regeltreue und nachvollziehbaren Begründungen.

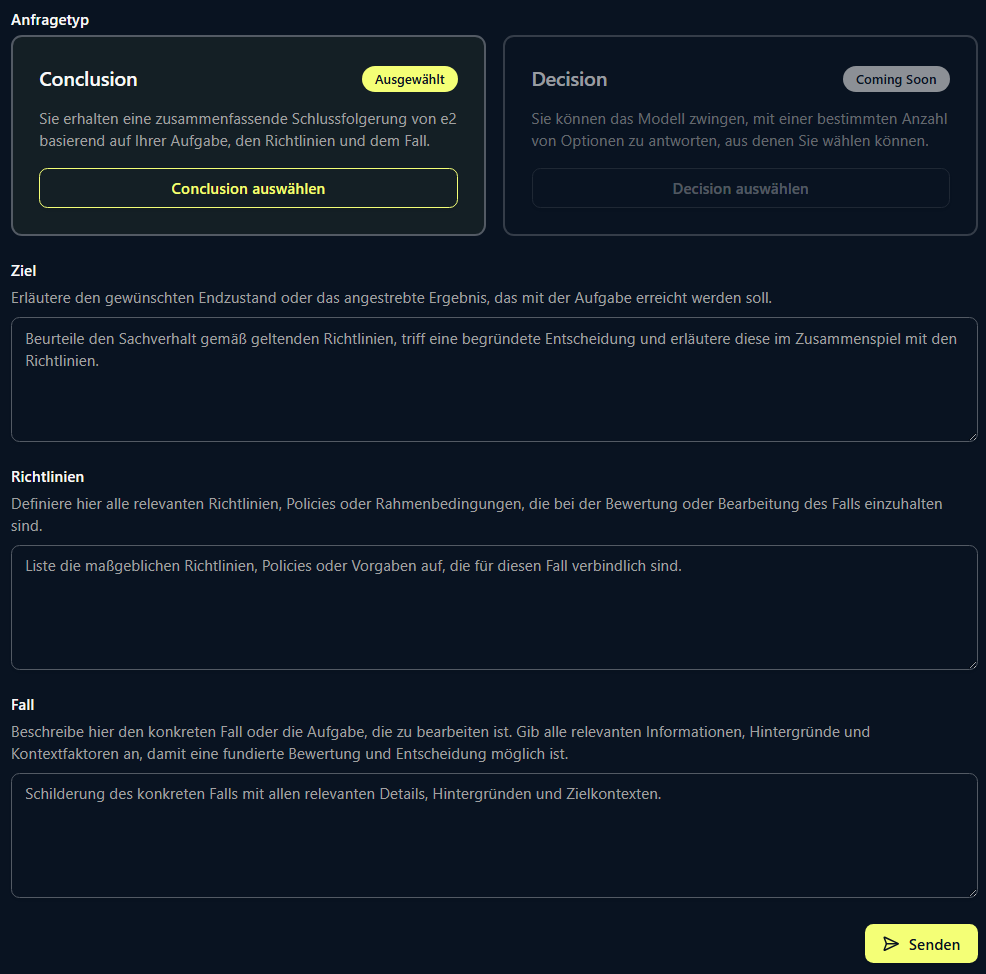

Du kannst Dir nun den oben gezeigten Case, inklusive sämtlicher Details zu Herleitungen und Begründungen, in Gänze ansehen. Dazu brauchst Du keinen Account und kein Login. Einfach auf den Link klicken und de Entdeckungsreise starten.

Alternativ kannst Du Dir aber auch einen kostenlosen Account für die Conclusion UI erstellen und mit einem eigenen Fallbeispiel in einer Sandbox-Umgebung die ersten eigenen Gehversuche unternehmen.

Wenn Du Support brauchst, sind wir jederzeit zur Stelle.

Unsere Conclusion Models bewähren sich bereits in einer Vielzahl produktiver Anwendungsfälle, bei denen es allesamt auf hochwertige und strukturierte Schlussfolgerungen mit entsprechender Transparenz und Nachvollziehbarkeit ankommt. Die nachfolgenden Beispiele zeigen einen Querschnitt über unterschiedliche Fachgebiete und Prozess-Gruppen im Unternehmen im Rahmen automatisierter Fall-Vorverarbeitung.

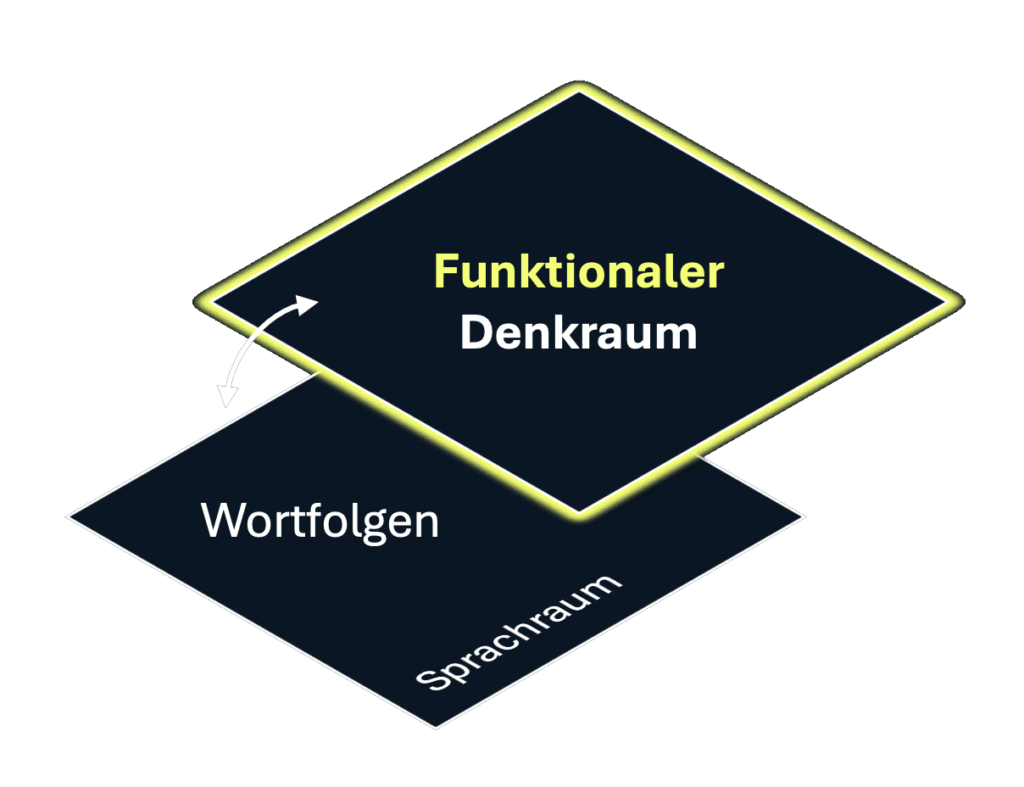

Wie Sprache und funktionales Denken interagieren

CCMs sind keine „besseren LLMs“, da sie über einen eigenständigen, zweiten Repräsentationsraum verfügen.

Denken im Sprachraum ist strukturell limitiert: je länger die Gedankenketten, desto tendenziell instabiler werden die Ergebnisse.

Die explizite Denk-Architektur der CCMs ermöglicht die Strukturierung & Stabilisierung langer Gedankenketten, und steigert damit die Qualität der Schlussfolgerungen — insbesondere dann, wenn normative Vorgaben und Vorschriften zu beachten sind.